מדריך מהיר לכתיבת קובץ Robots.txt

איך מתייעצים בספר לימוד ענק? סינון דרך האינדקס. ובכן: יש מרכיב אחד שהוא הסיכום האמיתי של האתר שלך...

הדרך היחידה ליצור קשר עם עכביש מנוע החיפוש, כלומר הסורק, זה דרך קובץ שנקרא robots.txt. או יותר טוב. כאשר אתה מגיש את הצעת האתר שלך לגוגל, היא מתמודדת עם כמות פשוט עצומה של מידע.

איך אתה יכול להתייעץ עם ספר לימוד שהוא כל כך גדול שאתה מרגיש שלעולם לא תמצא את כל מה שאתה צריך? לְהִתְיַעֵץ המדד. ובכן: קובץ robots.txt הוא האינדקס של האתר שלך.

זהו מסמך קל למילוי שאומר לסורק מנוע החיפוש על מה עליו להסתכל. בקיצור: תעזרו לו להבין ממה האתר שלכם עשוי, כך שהאלגוריתם יוכל לתת לכם דירוג תואם את העבודה שעשיתם.

האם כל אחד יכול לכתוב קובץ robots.txt?

התשובה הקצרה היא כן. התשובה הכנה היא לא. למרות שהדקדוק של קובץ robots.txt הוא פשוט ביותר, והרכבו הוא רק כמה שורות, עדיף להפקיד את הטיפול של מנהל אתרים מומחה שיודע היכן לשים את ידיו. אחרי הכל, מספיקה רק טעות אחת קטנה כדי לפגוע במיקום האתר שלך, ולכן לשלוח את כל פעולות ה-SEO להרוס עוד לפני שהן התחילו.

לפני שנתחיל, דע דבר אחד: כל אחד יכול לעיין בקובץ robots.txt של כל אתר על ידי כתיבת, אחרי הדומיין, /robots.txt. אתה יכול אפילו להתייעץ עם גוגל!

ניתן לכתוב קובץ מסוג זה מבלי להוריד תוכנה מיוחדת. למעשה, מספיק להשתמש בפנקס הרשימות ולשמור, נחשו מה, בפורמט txt.

בואו נכתוב ביחד robots.txt: הכותרת

נתחיל מההתחלה, כפי שתמיד הגיוני לעשות. פתיחת הקובץ, או הכותרת, מוקדשת כולה לשם העכביש, ולפניו ניסוח קטן שתמיד זהה. אנו מניחים שאתה רוצה שגוגל תשים לב אליו. אז השורה הראשונה תהיה:

סוכן משתמש: Googlebot

מחרוזת קצרה מאוד זו מציינת לגוגל שכל מה שאחריו בהחלט יעניין אותה. במקרה שאתה רוצה שכל הסורקים שקוראים קובץ מסוג זה יוכלו לעיין במסמך, החלף את Googlebot ב-* פשוט, א כוכבית.

כעת לאחר שציינת איזה עכביש, כלומר מי, תצטרך לציין גם מה שאתה צריך לקרוא.

כל שורת קוד, בהגדרה, מתאימה לפעולה של המכונה. מובן מאליו שכל פקודה בקובץ robots.txt מתאימה למה שהמכונה לא צריכה לעשות. וזה המפתח שמאפשר לך לכתוב אחד יעיל באמת. אנחנו מדברים על הפקודה DISALLOW.

מהי הפקודה DISALLOW?

Il לא לאפשר פקודה זה מאפשר לך לחשוב על ידי הדרה. במילים אחרות, כשהם אומרים שמהר יותר לומר מה אסור לעשות - ובכן, אתה מנמק בהדרה. בנוסף ל-disallow יש גם היתר, או החריגה לחסימה.

אם אתה רוצה לכתוב קובץ רובוטים טוב, תצטרך לחשוב לאחור, אז תצטרך להגיד לגוגל מה הוא לא אמור לקרוא. אם אתה כותב:

איסור:

העכביש יקרא את כל האתר שלך, ללא כל בלמים.

אם לאחר "Disallow:" תכניס קו נטוי (לכן Disallow: /), האתר לא ייכלל במנועי החיפוש, נקודה.

Disallow: /directory/

החלף את ספריית המילה בתיקייה שאתה רוצה שתדחה לעכביש. אתה יכול לעשות את אותו הדבר עם קובץ ספציפי.

Disallow: /filepersonale.html

היזהר מ סימני פיסוק ואותיות, אותיות גדולות או קטנות. סוג זה של קבצים לוקח את הסוג הזה של "זוט" בחשבון גבוה, אבל זה עושה הבדל גדול.

מדוע עליך לחסום את גוגל מלקרוא חלק גדול מהאתר שלך? כאשר כותבים קובץ מסוג זה, חשוב להבין אילו קבצים לא אמורים להופיע במנוע החיפוש, אך מבלי לעשות בהם שימוש לרעה. עם זאת, דע שמי שיודע את הכתובת המדויקת של אותו קובץ מסוים יוכל לגשת אליו בכל מקרה.

מהי הפקודה ALLOW?

בקובץ ניתן להוסיף חריגה עם הפקודה להתיר. הדקדוק זהה, אבל הוא ייצור חריגים ל-DISALLOW שיפתחו שולי חקירה מעניינים עבור העכביש.

קובץ דוגמה קטן:

סוכן משתמש: Googlebot

Disallow: /images/

אפשר: /images/vacanze.jpg

בעיקרון אמרנו ל-Googlebot לא להתייחס לתיקיית התמונות, למעט תמונה אחת בתוכה, כלומר החג.

וזהו, חבר'ה, זהו. כתבנו את קובץ robots.txt הראשון שלנו. בטח, מה שאנחנו הולכים ליצור עבור האתר בפועל עשוי להיות שונה במקצת, אבל לא בהרבה. אם יש לך ספק, תמיד קבל עצה ממנהל אתרים מומחה. אנו ממליצים לך לנסות לכתוב את זה בעצמך, קודם כל, ולשלוח לו את זה לבדיקה, כדי לשלוט על היסודות ולהבין טוב יותר איך האתר שלך עובד.

מה המתאם בין robots.txt ל-Sitemap?

מפת האתר היא קובץ שנוצר על ידי תוספים מיוחדים המכיל את כל הקישורים באתר. כאשר העכביש נכנס לאתר, הוא קודם כל קורא את הרובוטים, ואז סורק את האתר. אם במהלך סריקת הרובוטים הוא ימצא את כתובת מפת האתר, כל התהליך יהיה הרבה יותר קל.

הוסף את הדברים הבאים לקוד למעלה:

מפת אתר: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

לסיכום

כל קבצי הרובוטים זהים. זה אומר שקובץ רובוטים שנכתב עבור גוגל יהיה בסדר גם עבור בינג, ועוקב אחר אותו דקדוק.

קובץ robots.txt מאורגן היטב מאפשר לך לחסוך זמן של הסורק. אל תתייאש: זה הצעד הראשון להצלחה!

אולי יעניין אותך גם ב:

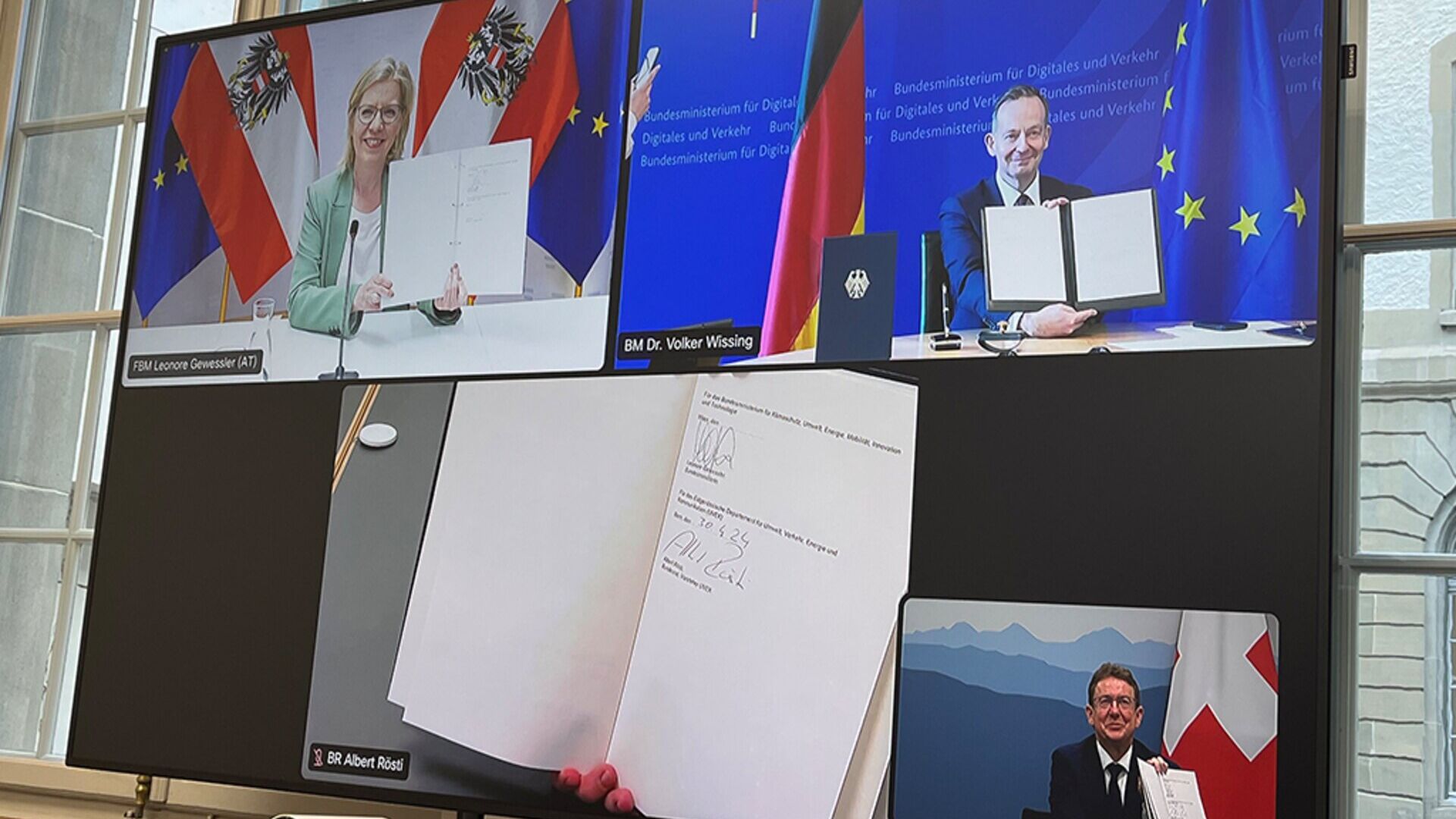

אוסטריה, גרמניה ושוויץ עבור מסילות מטען "חדשניות יותר".

שרי DACH ליאונור ווסלר, וולקר וויסינג ואלברט רוסטי: הצגת ההתאמה הדיגיטלית האוטומטית היא מרכיב מרכזי

שכנוע או מניפולציה? בראשית והשפעה היסטורית של יחסי ציבור

כך ממשיכים יחסי ציבור, מהדיאלוג הסופי של יוון העתיקה ועד לעידן הדיגיטלי הנוכחי, להציע חדשנות מתמשכת

צעירים ומטבעות קריפטוגרפיים: איך לגלות עוד על ביטקוין...

להכיר לילדים מטבעות דיגיטליים ובלוקצ'יין יכולה להיות מאמץ מרגש, לאור הזיקה שלהם לטכנולוגיה וחדשנות

"המטופל במרכז": תקווה גדולה ופגישה בסנאט

נושא החשיבות של חדשנות במכשירים רפואיים עבור שירותי בריאות אירופיים ייבחן ב-15 במאי ברומא על ידי מומחים ופוליטיקאים

מאת אלברטו ניקוליניעורך של districtbiomedicale.it, BioMed News ו-Radio Pico